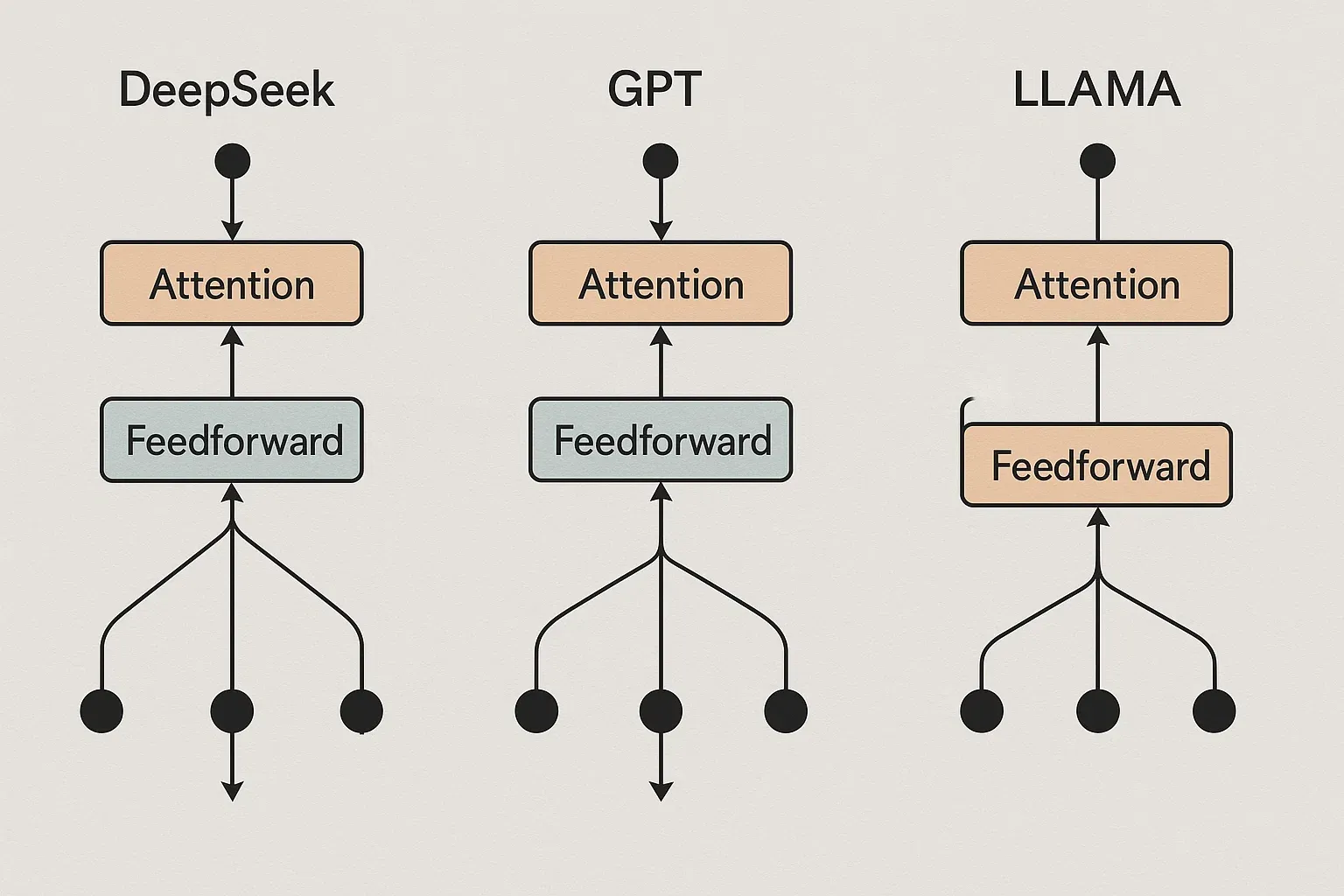

В мире нейросетевых языковых моделей одна из ключевых технологий, определяющих успех архитектуры, — это attention-механизмы. Они позволяют модели эффективно фокусироваться на значимых частях входной последовательности и строить более глубокое контекстное понимание текста. Среди крупных моделей последних лет особое внимание привлекли GPT (особенно GPT-4), LLaMA от Meta и новый игрок — DeepSeek. Последний использует собственный подход к attention, и его отличия стали предметом живого интереса в профессиональном сообществе.

Цель этой статьи — доступно и подробно рассказать, как реализованы attention-механизмы в DeepSeek, чем они отличаются от аналогичных компонентов в GPT и LLaMA, и как это влияет на качество и производительность модели. Мы рассмотрим технические особенности без погружения в код, используя простой язык, таблицы и списки, чтобы объяснение было понятным и логически последовательным.

Базовое понимание self-attention

Прежде чем сравнивать конкретные архитектуры, важно кратко понять, что вообще такое self-attention. Это механизм, при котором модель анализирует каждое слово (или токен) не изолированно, а во взаимодействии со всеми остальными токенами в предложении. Грубо говоря, self-attention отвечает на вопрос: «На какие части текста мне стоит обратить внимание, чтобы правильно понять значение текущего слова?»

Внутри модели создаются три вида представлений: query (запрос), key (ключ) и value (значение). Каждый токен получает собственные query, key и value-векторы. Attention рассчитывается как сопоставление query одного токена с ключами всех остальных, чтобы понять, какие из них наиболее релевантны.

В результате мы получаем взвешенное представление, в котором учитывается контекст. Именно это делает self-attention особенно мощным при обработке длинных и сложных текстов.

Особенности attention-механизма в GPT

В архитектуре GPT, начиная с версии GPT-2 и особенно в GPT-3 и GPT-4, применяется классическая реализация self-attention с маскировкой будущих токенов (masked attention). Это значит, что каждый токен может «видеть» только себя и предыдущие токены, но не будущее. Такой подход логичен для автодополнения текста и генерации — модель по сути пишет текст слева направо.

GPT также использует multi-head attention — это когда внимание разбивается на несколько параллельных «голов», каждая из которых учится фокусироваться на разных аспектах контекста. Это даёт модели возможность учитывать сразу несколько факторов — например, грамматическую структуру, смысловые связи и прочее.

Сложность GPT в плане attention заключается в том, что при увеличении длины входа (например, при работе с контекстами длиной 8k или 32k токенов) сильно растут вычислительные затраты. Стандартный self-attention масштабируется квадратично по длине последовательности — это один из главных ограничивающих факторов.

Что делает LLaMA: оптимизация веса и памяти

LLaMA от Meta — это попытка создать более лёгкую, но всё ещё мощную модель. Основное отличие в attention здесь не столько концептуальное, сколько техническое и оптимизационное. LLaMA, особенно начиная с версии LLaMA-2, использует:

-

Flash Attention — алгоритм, снижающий затраты памяти и ускоряющий вычисления;

-

нормализацию внутри attention-блоков для лучшей устойчивости обучения;

-

постактивационные функции (Post-LN), что отличает её от GPT, где применяется Pre-LN.

Важно, что LLaMA делает ставку на экономичность. Она сохраняет схему masked self-attention, но фокусируется на архитектурной экономии. При одинаковом числе параметров LLaMA показывает схожую или лучшую производительность, чем GPT, при меньших ресурсах.

Также стоит отметить, что LLaMA использует Rotary Positional Embeddings (RoPE) для кодирования позиций токенов — это более гибкая альтернатива традиционным позиционным кодировкам и позволяет лучше масштабировать attention при работе с длинными контекстами.

Инновации DeepSeek: attention с разреженной плотностью

DeepSeek — это относительно новая языковая модель, которая активно развивается в Азии, особенно в Китае. Её создатели сделали акцент на гибридный attention-подход, сочетающий плотное и разреженное внимание (dense + sparse attention). Главные особенности этой модели:

-

Комбинация глобального внимания с локализованным;

-

Гибкое переключение режимов в зависимости от плотности текста;

-

Предварительное обучение на смешанных доменах (код, текст, инструкции).

В отличие от GPT и LLaMA, где каждая attention-голова сканирует всё подряд (пусть и с оптимизациями), DeepSeek применяет метод подвыборки: часть токенов рассматривается более пристально, часть — опционально. Это делает модель менее ресурсоёмкой и позволяет ей обрабатывать более длинные контексты с меньшими затратами.

Таблица сравнения attention-подходов

| Характеристика | GPT-4 | LLaMA-2 | DeepSeek |

|---|---|---|---|

| Тип attention | Masked dense | Masked dense | Гибридный (dense + sparse) |

| Оптимизация скорости | Multi-head only | Flash Attention | Статическая маска + sparse |

| Позиционные эмбеддинги | Absolute | RoPE | RoPE + адаптивные токен-сетки |

| Масштабируемость по контексту | Ограниченная | Средняя | Высокая |

| Использование памяти | Высокое | Умеренное | Низкое |

Эффект на производительность и выводы из тестов

Сравнительный анализ attention-механизмов показывает, что DeepSeek даёт прирост в производительности именно за счёт своей гибридной архитектуры. В независимых тестах модель показывает отличные результаты по пониманию длинных текстов, инструкций и кода — именно там, где традиционный dense attention буксует.

Важно подчеркнуть, что разреженность не означает «пропуски» в понимании. Напротив, благодаря предварительной обученной маске, модель всё равно обращает внимание на нужные участки текста. Это чем-то похоже на поведение человека: мы не читаем каждое слово подряд, но быстро находим суть благодаря внутренним фильтрам.

Список ситуаций, где DeepSeek превосходит другие модели:

-

Работа с длинными юридическими документами;

-

Генерация инструкций в стиле StackOverflow;

-

Разговорные агенты с динамической памятью;

-

Компактные приложения на мобильных устройствах.

С другой стороны, при коротких задачах (до 1k токенов) разница между моделями практически исчезает, и attention становится узким горлышком только при серьёзной нагрузке.

Потенциал и ограничения гибридного внимания

Гибридный attention в DeepSeek открывает интересные перспективы. Благодаря меньшим затратам, модель можно запускать на более слабом оборудовании. Это особенно важно для embedded-сценариев, где ресурсы ограничены.

Тем не менее, у такого подхода есть ограничения:

-

Сложнее интерпретировать поведение модели: какие токены были выделены и почему — не всегда понятно;

-

При нестабильных данных (например, плохо размеченных инструкциях) модель может «ошибиться» в приоритетах внимания;

-

Обучение такой архитектуры требует больше инженерной работы, чем стандартный dense attention.

Сравнение преимуществ attention-реализаций:

-

GPT выигрывает в классической генерации, где контекст — линейный и предсказуемый;

-

LLaMA хороша в экономичных сценариях с плотной загрузкой GPU;

-

DeepSeek — в задачах с переменной длиной, сложной структурой и ограниченными ресурсами.

Где attention-механизм DeepSeek особенно полезен

-

В больших чат-ботах со встроенной памятью;

-

В задачах code completion и анализа исходников;

-

В мультимодальных системах, где требуется фильтрация текста по смыслу;

-

В системах генерации отчётов, где важен выбор ключевых фрагментов.

Заключение

Attention-механизмы остаются сердцем современных языковых моделей. Их развитие определяет, насколько эффективно модель может работать с контекстом, какие объёмы текста она способна обработать и какова её вычислительная стоимость.

DeepSeek показал интересный подход, объединив плотное и разреженное внимание, чтобы достичь баланса между точностью и скоростью. В сравнении с GPT и LLaMA он демонстрирует высокий потенциал в специализированных задачах, особенно там, где необходима работа с большими объёмами информации при ограниченных ресурсах.

Однако будущее моделей с гибридным attention зависит от качества обучения, архитектурных доработок и способности адаптироваться к новым доменам. DeepSeek — это не просто альтернатива, а потенциальное новое направление в эволюции языковых моделей, особенно в условиях растущего спроса на экономичность и масштабируемость.