С развитием искусственного интеллекта и языковых моделей появилась возможность автоматизировать создание текстов для разных задач — от поддержки клиентов до генерации описаний товаров и даже сценариев. Однако сам по себе LLM (Large Language Model) — это только ядро. Чтобы использовать его в реальных проектах, нужна надёжная серверная архитектура, которая позволит взаимодействовать с моделью через API. В этой статье мы подробно рассмотрим, как связать FastAPI — современный фреймворк для Python — с DeepSeek — языковой моделью с открытым доступом. Вместе они позволяют быстро развернуть генеративный API, гибко управлять параметрами и масштабировать решения.

Разберёмся, как работает такая связка, какие есть преимущества у FastAPI в этом контексте, как эффективно использовать DeepSeek в качестве генератора текста, и на что стоит обратить внимание при создании backend-архитектуры. Для разработчиков и бизнесов, желающих интегрировать генерацию текста в своё приложение, этот материал станет практическим путеводителем.

Почему FastAPI — идеальный выбор для генеративного API

FastAPI стал популярным благодаря своей скорости, простоте и богатой документации. В отличие от старых решений вроде Flask, он предлагает автоматическое создание документации и высокую производительность из коробки. Это особенно важно при работе с языковыми моделями, где каждый запрос может быть ресурсоёмким.

FastAPI позволяет:

-

создавать RESTful API быстро и удобно;

-

управлять входными и выходными данными с помощью Pydantic;

-

масштабировать проект через асинхронность;

-

использовать автоматическую генерацию Swagger-документации.

Для интеграции LLM, таких как DeepSeek, важно, чтобы API быстро обрабатывал запросы, мог обрабатывать параллельные запросы от пользователей и был легко расширяем. FastAPI справляется с этими задачами лучше большинства аналогов, особенно при использовании в сочетании с асинхронными вызовами.

Что такое DeepSeek и почему он популярен

DeepSeek — это открытая языковая модель, которая предлагает сопоставимое качество с коммерческими аналогами. Её главное преимущество — свободный доступ и возможность размещения на собственных серверах. Это особенно важно в контексте приватности, кастомизации и стоимости.

DeepSeek предлагает несколько моделей разных размеров, от базовых до более продвинутых, способных выполнять сложные задания по генерации текста. Модель обучена на больших корпусах и поддерживает различные языки, включая русский. Она легко адаптируется под специфические нужды и может быть дообучена при необходимости.

Её возможности включают:

-

генерацию текста на заданную тему;

-

ответы на вопросы;

-

составление описаний;

-

трансформацию текста по стилю или длине.

Таким образом, DeepSeek можно использовать как движок для генерации, а FastAPI — как оболочку для его вызова через API.

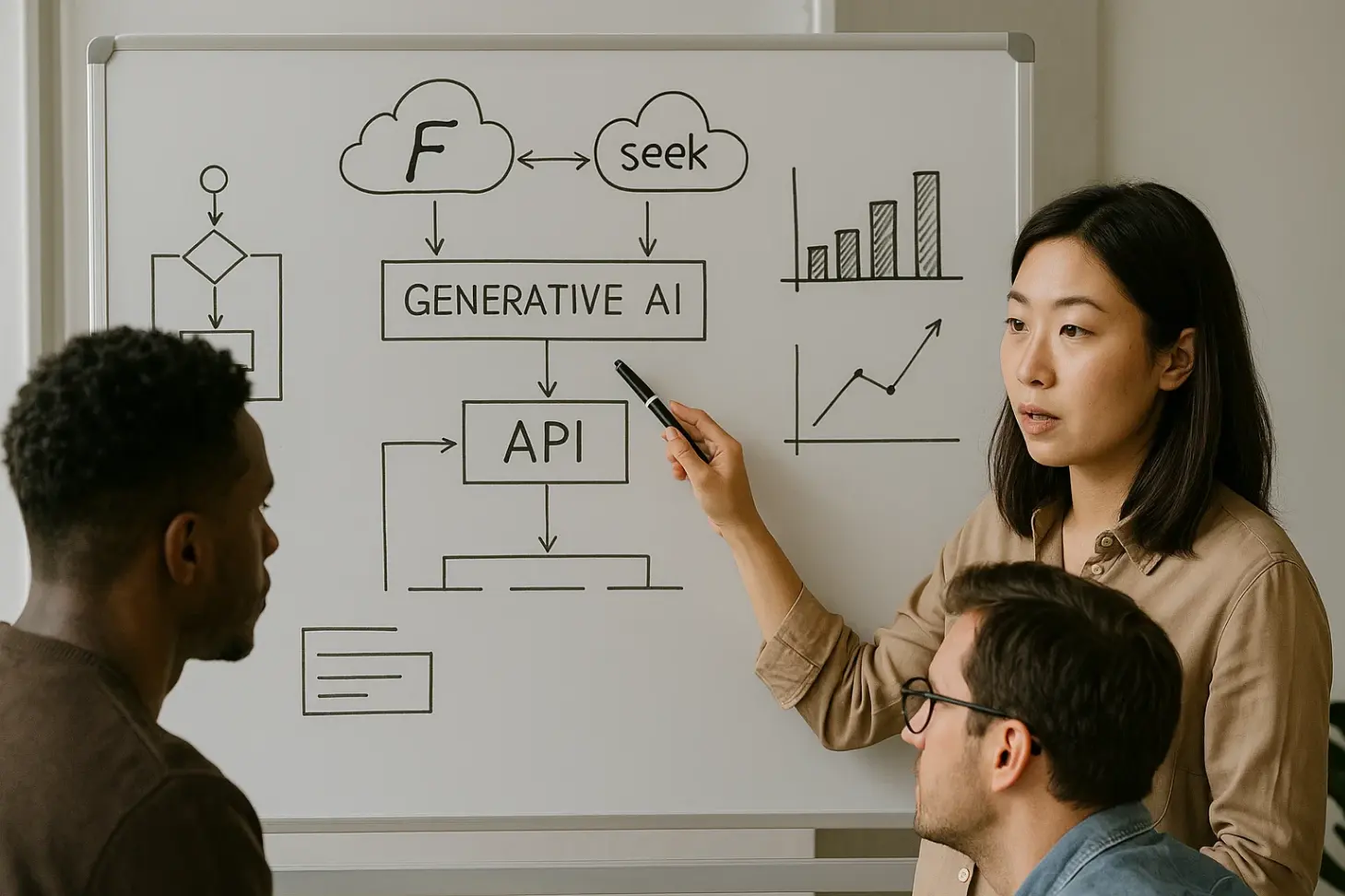

Архитектура генеративного API: взаимодействие FastAPI и DeepSeek

Чтобы построить работающий API, необходимо наладить чёткое взаимодействие между клиентом, FastAPI и моделью DeepSeek. Общая схема взаимодействия будет выглядеть так:

| Компонент | Описание |

|---|---|

| Клиентское приложение | Отправляет запрос на генерацию текста через API |

| FastAPI-сервер | Получает запрос, валидирует входные данные, вызывает модель |

| DeepSeek backend | Отвечает на запрос генерацией текста |

| Ответ клиенту | Возвращается от FastAPI обратно клиенту |

В этом процессе FastAPI играет роль посредника, обеспечивая валидацию данных и маршрутизацию. DeepSeek запускается либо как отдельный процесс (через Python API или Web API), либо через обёртку, интегрированную в backend.

Чтобы это работало стабильно, важно:

-

Обеспечить стабильный запуск DeepSeek на сервере.

-

Проконтролировать объём памяти и использование GPU.

-

Установить таймауты и лимиты по токенам для предотвращения перегрузок.

-

Обработать ошибки, если модель не отвечает или возвращает неожиданный результат.

Как спроектировать эффективный запрос к DeepSeek

Успех генерации зависит не только от модели, но и от того, как правильно формулируется запрос. В генеративном API каждый вызов содержит параметры: prompt, максимальная длина, температура (степень креативности), топ-к и топ-п (ограничения вероятности). Гибкая настройка позволяет создавать как строгие, так и креативные тексты.

Вот основные параметры, которые нужно предусмотреть в API:

-

prompt— текст-задание, который подаётся на вход модели; -

max_tokens— максимальное количество токенов в ответе; -

temperature— степень случайности генерации (от 0 до 1); -

top_pиtop_k— ограничение вероятностного распределения.

Пример грамотной настройки API-запроса:

-

для создания описания продукта: низкая температура (0.2), высокая точность;

-

для креативного письма: высокая температура (0.9), длинный ответ;

-

для перевода или переформулировки: средняя температура, ограниченный max_tokens.

Такой подход даёт клиенту гибкость, позволяя адаптировать модель под конкретную задачу без переписывания backend-логики.

Управление производительностью и масштабирование

Когда API начинает использоваться в продакшене, ключевым становится вопрос производительности. Работа языковых моделей требует ресурсов, особенно при генерации больших текстов. Вот ключевые моменты, на которые стоит обратить внимание.

Во-первых, нужно контролировать количество параллельных вызовов. Для этого можно:

-

использовать очередь задач (например, с Celery);

-

ограничивать частоту запросов через rate limit;

-

логировать использование API для анализа и масштабирования.

Во-вторых, важно мониторить нагрузку на сервер. Особенно, если DeepSeek работает на GPU. Регулярный анализ использования видеопамяти и времени отклика поможет заранее выявить узкие места.

Наконец, стоит предусмотреть масштабируемость. Возможные подходы:

-

Горизонтальное масштабирование (несколько серверов с балансировкой);

-

Кэширование часто используемых ответов;

-

Прогревание модели при запуске.

Чтобы не перегружать систему, можно заранее определить приоритетные сценарии — например, если большая часть запросов связана с генерацией писем, оптимизировать модель под эти задачи.

Возможности кастомизации DeepSeek под конкретные задачи

Открытая архитектура DeepSeek даёт возможность не только использовать модель, но и дообучать её. Это может понадобиться в следующих случаях:

-

специфический стиль написания (технический, маркетинговый);

-

термины и лексика из конкретной отрасли;

-

соблюдение тональности бренда.

Возможности дообучения:

-

дообучение на собственном датасете;

-

настройка prompt-шаблонов без переобучения модели;

-

постобработка текста (фильтры, корректоры).

Также можно создать несколько моделей DeepSeek, каждая из которых адаптирована под конкретный тип задач, и вызывать нужную в зависимости от запроса.

Для более гибкой работы стоит предусмотреть следующие возможности в API:

-

выбор «режима» генерации (например: рекламный, технический, нейтральный);

-

возможность указать ключевые слова, которые нужно включить в текст;

-

указание стиля, тона или длины ответа.

Таким образом, API становится не просто генератором, а инструментом контент-менеджмента.

Как избежать типичных ошибок при создании генеративного API

Создание API для генерации текста — не просто запуск модели. Это целая архитектура, требующая внимания к деталям. Вот распространённые ошибки, которых стоит избегать:

-

Недостаточная валидация входных данных. Без этого легко получить неожиданные ошибки или перегрузки.

-

Отсутствие контроля за ресурсами. Генерация больших текстов может съесть всю память сервера.

-

Использование одной конфигурации генерации для всех сценариев. Лучше предложить несколько пресетов.

-

Отсутствие логирования. Без истории запросов сложно анализировать производительность и отладку.

-

Слишком высокая температура генерации по умолчанию, из-за чего тексты теряют смысл.

Вот удобный перечень минимальных требований, которые нужно реализовать для стабильного запуска:

-

базовая валидация входных параметров;

-

настройка лимитов на длину и частоту запросов;

-

логирование всех вызовов и времени их выполнения;

-

обработка ошибок и возврат информативных сообщений;

-

выбор между CPU и GPU в зависимости от ресурсов.

Эти меры позволят не только обеспечить стабильность, но и подготовить систему к росту нагрузки.

Заключение

Интеграция DeepSeek и FastAPI — мощное решение для создания генеративного API. С одной стороны, FastAPI обеспечивает быстрый и структурированный backend. С другой — DeepSeek даёт высокое качество генерации и гибкость. Вместе они позволяют бизнесам и разработчикам реализовать интеллектуальные решения без зависимости от облачных сервисов и высоких затрат.

Такой API можно использовать в самых разных сферах: от поддержки клиентов до создания маркетингового контента и образовательных решений. Главное — подойти к проектированию вдумчиво: предусмотреть сценарии, ограничить риски и обеспечить стабильность.

Сильной стороной такой архитектуры является открытость. Вы можете полностью контролировать процесс, адаптировать модель, интегрировать с другими сервисами и развивать API вместе с потребностями бизнеса. Это делает FastAPI и DeepSeek отличной связкой для тех, кто хочет создать что-то своё — производительное, гибкое и интеллектуальное.